H2O Eval Studio是什么

H2O Eval Studio是H2O.ai推出的AI模型评估与监控平台,用于对大语言模型(LLM)和AI助手的输出进行系统化测试、比较和分析。通过可配置的评估指标(如相关性、忠实度、上下文召回率等)和自定义评测套件,提供可解释的执行级洞察、支持多模型横向对比、允许用户自定义业务相关评估规则,确保AI系统可靠、合规、符合业务目标。帮助金融、法律等企业在部署前发现模型幻觉、偏见或性能退化问题。

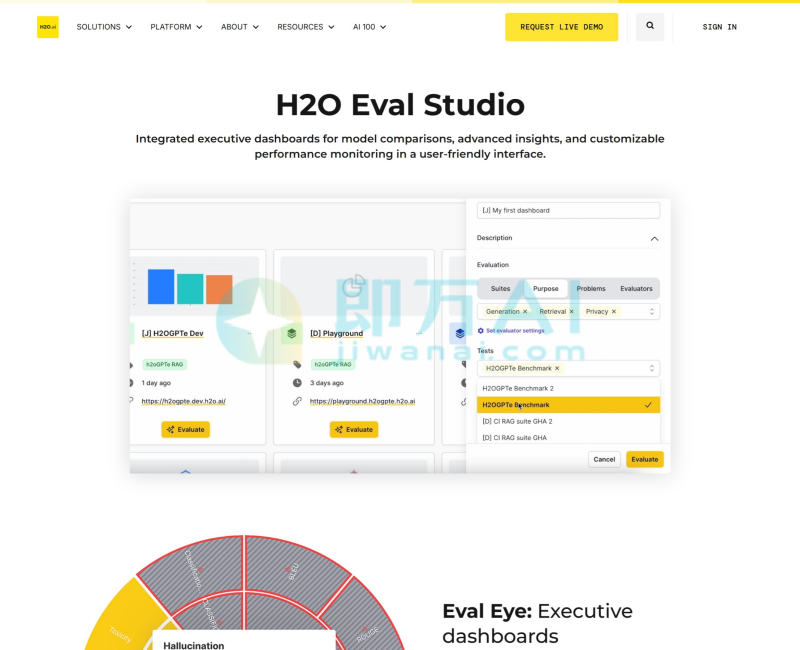

H2O Eval Studio的主要功能

- 多维度自动评估:内置Ragas、Faithfulness、Answer Relevancy、Context Precision等主流指标,量化模型表现。

- 自定义评测器:支持用户编写Python逻辑或使用自然语言定义专属评估规则,贴合具体业务场景。

- 模型与排行榜对比:可同时运行多个模型或不同版本,生成可视化对比报告,快速识别最优方案。

- 执行级调试视图:展示每条测试用例的输入、上下文、模型输出及评分细节,便于定位失败原因。

- 测试用例扰动:通过添加噪声、改写问题等方式测试模型鲁棒性,暴露潜在脆弱点。

- 企业级集成:与H2O AI Cloud、h2oGPTe无缝对接,支持API调用和CI/CD流水线集成。

- 可视化仪表盘:提供Executive Dashboard,供非技术决策者监控关键性能趋势与风险指标。

H2O Eval Studio官网地址:

官网:h2o.ai

H2O Eval Studio的应用场景

- 金融风控问答系统验证:评估AI客服对合规条款的回答是否准确、无幻觉。

- 电信智能坐席上线前测试:确保模型能正确理解用户意图并引用最新资费政策。

- 政府公文生成审核:检查AI起草文件是否忠实于原始材料、无事实偏差。

- 医疗信息检索评估:验证模型从医学文献中提取的答案是否可靠、可追溯。

- 内部AI助手迭代优化:在每次模型微调后,自动运行回归测试,防止性能倒退。

- 供应商模型选型:横向对比多家LLM在企业私有数据上的表现,辅助采购决策。

H2O Eval Studio常见问题有哪些

- 是开源工具吗?

不是。H2O Eval Studio 是 H2O.ai企业级产品的一部分,需通过H2O AI Cloud订阅使用。 - 需要写代码吗?

基础评估可通过界面配置;若需自定义逻辑,则需Python或自然语言定义评估规则。 - 支持私有模型评估吗?

支持。可连接本地或私有云部署的LLM,所有数据不出企业环境。 - 能评估非英文内容吗?

可以。只要评估指标适配,即可用于中文、西班牙语等多语言场景,已有客户用于中文金融问答测试。 - 和LangSmith、DeepEval比有什么区别?

H2O Eval Studio更强调企业治理与可审计性,提供执行追踪、合规报告和高管看板,适合强监管行业;而LangSmith更偏向开发者调试。 - 有免费试用吗?

官网提供“Request a Demo”入口,企业用户可申请沙箱环境体验完整功能,但无公开免费版。

相关导航

暂无评论...