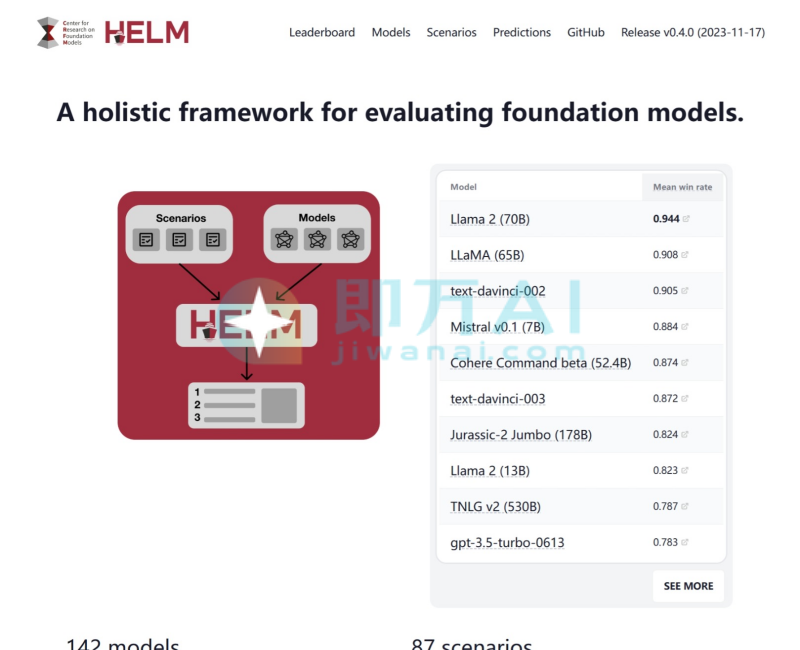

HELM是什么

HELM是由斯坦福大学CRFM主导开发的AI大语言模型综合评测体系。通过在数十种场景(如问答、推理、毒性检测、多语言理解等)下对模型进行标准化测试,提供可复现、透明、细粒度的性能评估。优势在于覆盖全面、指标统一、开源透明、支持跨模型横向比较,旨在解决早期AI评测“碎片化、不可比、缺乏上下文”的问题,已成为学术界和工业界公认的权威基准之一。

HELM的主要功能

- 多维度场景评测:涵盖58+个子场景,包括MMLU(多任务知识)、TruthfulQA(事实性)、ToxiGen(毒性)、BBQ(社会偏见)、GSM8K(数学推理)等。

- 标准化提示与指标:所有模型在相同输入格式、评估协议下运行,确保结果公平可比。

- 细粒度指标展示:不仅提供总体得分,还按能力维度(如知识、推理、鲁棒性、公平性、效率)拆解表现。

- 开源与可复现:代码、数据、评估脚本全部公开,支持社区贡献新场景或模型接入。

- 动态排行榜:实时更新140+个模型(如GPT-4、Claude、Llama、Gemini等)在各场景下的表现排名。

- 支持自定义评估:研究者可提交私有模型或新评测任务,经审核后纳入官方体系。

HELM官网地址:

官网:crfm.stanford.edu

HELM的应用场景

- 学术研究基准:论文发表前用于验证新模型是否在通用能力上超越现有SOTA。

- 企业模型选型:技术团队通过HELM对比不同开源或闭源模型在目标任务上的优劣。

- 政策与安全评估:监管机构参考其偏见、毒性、隐私泄露等指标评估AI系统风险。

- 教育与教学:高校课程用HELM讲解大模型能力边界与评测方法论。

- 开源社区贡献:开发者基于HELM框架新增本地化场景(如中文、东南亚语言)扩展评测覆盖。

HELM常见问题有哪些

- 能直接测试我的模型吗?

可以。HELM开源代码托管于GitHub,支持本地部署评估;若想加入官方排行榜,需按规范提交结果并接受审核。 - 只测英文吗?

主榜单以英文为主,但已逐步纳入多语言场景,如ThaiExam(泰语考试)、SEA-HELM(东南亚语言)、CLEVA(中文综合评测)等。 - 和MMLU、BIG-Bench有什么区别?

MMLU仅测知识,BIG-Bench侧重创意任务;HELM是整合型框架,将多个已有基准标准化后统一运行,提供更系统视角。 - 结果可信吗?

高度可信。所有实验在统一环境(相同提示模板、采样参数、评估器)下执行,避免“调参刷榜”问题。 - 普通用户能看懂报告吗?

官网提供交互式图表,支持按模型、场景、指标筛选;非技术用户可关注“Mean Win Rate”(平均胜率)等汇总指标快速比较。

相关导航

暂无评论...